EU AI Act超入門!中小企業のIT担当者がはじめて社内会議でEU AI Actの話題を共有するときの決定版

※本記事のデータは2025年12月時点の情報に基づいています。EU AI Actの施行スケジュールや支援制度については、最新情報を各公式サイトでご確認ください。

「EU AI Act」という言葉を聞いたことはありますか?

「EUの規制だから、うちには関係ない」

そう思われた方も多いかもしれません。しかし、EU市場にAI製品やサービスを提供している日本企業、あるいはEU企業と取引のある企業は、規模に関わらずこの規制の対象となる可能性があります。

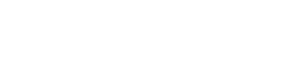

実際、2024年の日本からEUへの輸出総額は約9兆9,660億円にのぼります。主要輸出品目である機械・輸送機器(62%)や化学製品(11.9%)の中には、AIが組み込まれた製品も少なくありません。

(出典:EU-Japan Centre for Industrial Cooperation, 2025年4月レポート)

一方で、日本の中小企業のAI採用率はわずか16%。非採用企業の40%がAIの利点を認識しておらず、34%が技術専門知識の欠如を障壁として挙げています。

(出典:Rakuten Group調査、Edelman Data & Intelligence実施、2025年1月公表)

つまり、多くの中小企業がAI活用を検討する段階で、EU規制への対応という新たな課題に直面しているのです。

本記事では、IT担当者の方が社内会議で「EU AI Actとは何か」「当社に影響があるのか」「何をすべきか」を説明できるレベルまで、基礎から実務対応まで解説します。

そもそもAI(人工知能)とは何か?

EU AI Actを理解する前に、まず「AI」の基本を押さえておきましょう。

AIとは、通常は人間の知能を必要とする作業をコンピューターやマシンが実行できるようにする技術です。人間のように「学習」「推論」「問題解決」を行うことができます。

(出典:IBM “What Is Artificial Intelligence (AI)?” 2024年8月)

日常で使われているAIの例

- メールの迷惑メールフィルター

- スマホの音声アシスタント(Siri、Alexa)

- NetflixやAmazonの推奨システム

- ChatGPTのような会話型AI

- 自動運転車

- 顔認証システム

企業で使われているAIの例

- カスタマーサポート用チャットボット

- 採用スクリーニングツール(履歴書の自動選別)

- 与信スコアリングシステム(ローン審査)

- 在庫予測・需要予測AI

- 製造ラインの品質検査AI

- 顔認証による入退室管理システム

- 従業員の勤怠管理・監視システム

これらのAIは、EU AI Actにおいて異なる「リスクレベル」に分類され、それぞれ異なる規制要件が課されます。

EU AI Actとは何か?

EU AI Act(正式名称:Regulation (EU) 2024/1689 on Artificial Intelligence)は、2024年8月1日に発効した、世界初の包括的なAI規制フレームワークです。

3つの主要目的

- 基本的人権の保護:AIが人々の権利と自由を侵害しないようにする

- 安全性の確保:危険なAIシステムから市民を守る

- イノベーションの促進:明確なルールを設定し、企業が安心してAI開発できる環境を整備

GDPRとの違い

EU AI ActとGDPR(一般データ保護規則)は、どちらもEUの規制ですが、対象と焦点が異なります。

項目 | GDPR | EU AI Act |

規制対象 | 個人データの処理 | AIシステムの設計・提供・使用 |

焦点 | データ保護とプライバシー | AIシステムのリスクと安全性 |

適用範囲 | 個人データを扱う場合のみ | 個人データを扱わない場合も適用 |

罰金上限 | 売上の4%または2,000万ユーロ | 売上の7%または3,500万ユーロ |

(出典:ModelOp “EU AI Act vs. GDPR” 2024年4月)

重要なのは、GDPRと同様に「域外適用」があることです。日本企業でも、EU市場にAIシステムを提供する場合、または、EUでAIシステムの出力が使用される場合に適用されます。

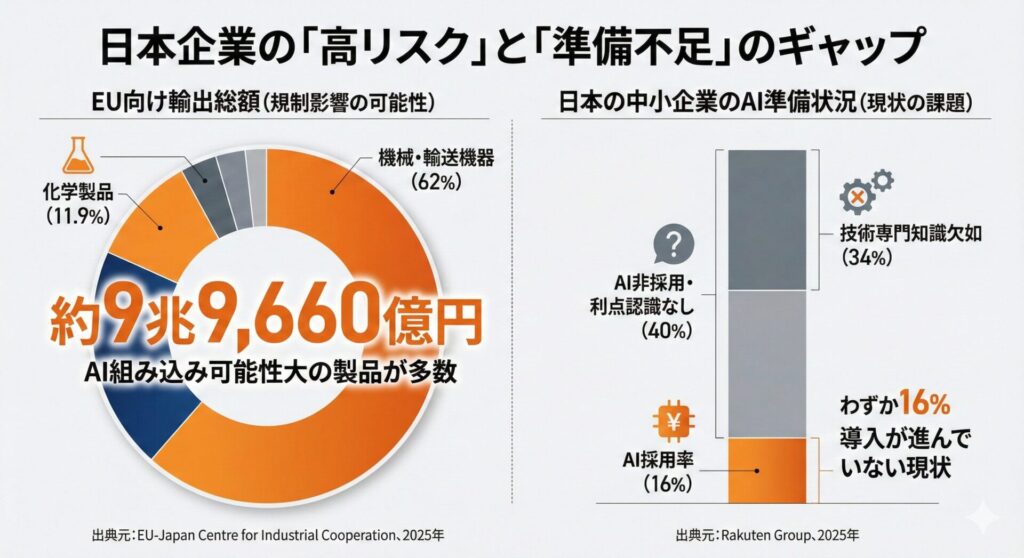

4つのリスクレベルを理解する

EU AI Actの最大の特徴は、AIシステムを4つのリスクレベルに分類し、リスクに応じて異なる規制要件を設定している点です。

レベル1:受け入れ不可能なリスク(完全禁止)

最もリスクが高いAIは、EU市場での提供・使用が完全に禁止されています。この規定は2025年2月2日に既に発効しています。

8つの禁止カテゴリー

- 潜在意識的操作・詐欺的技法:人々の行動を歪めるために潜在意識に働きかけるAI

- 脆弱性の搾取:年齢、障害、社会経済的状況などの脆弱性を搾取するAI

- ソーシャルスコアリング:人の社会的行動に基づいて格付けするAI

- 犯罪リスク予測:個人の人格特性のみに基づき犯罪を予測するAI

- 顔認証データベースの無差別拡張:インターネットやCCTVから顔画像を無差別にスクレイピング

- 職場・教育での感情認識:従業員や学生の感情を認識するAI

- 生体データからの属性推測:人種、政治的見解、性的指向などを推測するAI

- 公共場所での実時間遠隔生体認証:法執行目的でのリアルタイム顔認証(一部例外あり)

(出典:Algorithm Watch “As of February 2025: Harmful AI applications prohibited in the EU” 2025年1月)

違反した場合の罰金は、最大3,500万ユーロまたは総売上の7%(いずれか高い方)です。

レベル2:高リスク(厳格な規制要件)

以下の7つのカテゴリーに該当するAIシステムは「高リスクAI」として、厳格な規制要件が課されます。この規定は2026年8月2日に発効予定です。

7つの高リスクカテゴリー

- 生体認証:遠隔顔認証システム、生体属性に基づくカテゴリー分類、感情認識システム

- 重要インフラ:道路交通管理システム、水道・ガス・電力供給の管理、デジタルインフラの運用

- 教育と職業訓練:学生の成績評価AI、入学試験の自動採点、適職診断システム

- 雇用:採用スクリーニングツール、昇進・解雇判定AI、従業員監視・パフォーマンス評価システム

- 基本的公共サービス:信用スコアリング、保険料決定AI、住宅ローン審査、福祉給付の適格性判定

- 法執行:犯罪リスク評価、容疑者特定AI、証拠分析AI

- 移民・国境管理:出入国審査AI、ビザ決定システム、身分確認AI

(出典:EU AI Act公式テキスト Annex III)

実際に起きた事例

欧州のある採用企業が、ビデオ面接を基に応募者をスコアリングするAIシステムを使用していました。音声のリズムや顔の表情から判定していたところ、不公平な扱いの苦情を受け、高リスクAIとして調査されました。企業は人的監視を追加し、モデルの意思決定プロセスを文書化する必要がありました。

(出典:VerifyWise AI Lexicon “High-risk use cases under EU AI Act”)

レベル3:限定的リスク(透明性要件)

チャットボットや感情認識システム(高リスク以外)などが該当します。主な要件は、ユーザーへの明示的な通知です。

- 「あなたはAIと対話しています」

- AIが生成したコンテンツであることの表示

レベル4:最小限リスク(規制なし)

メールのスパムフィルター、ゲーム内AI、在庫管理システム、一般的な推奨エンジンなどが該当します。特定の規制要件はありませんが、従業員のAIリテラシー向上は推奨されています。

特別カテゴリー:汎用AI(GPAI)モデル

ChatGPT、GPT-4、Gemini、Claudeなどの大規模言語モデルは「汎用AI(GPAI)モデル」として、別途の要件が課されます。この規定は2025年8月2日に既に発効しています。

主な要件は以下の通りです。

- 技術文書の作成・維持

- 学習データの要約公開

- 著作権指令への対応ポリシー

- ダウンストリーム開発者への情報提供

(出典:欧州委員会 “Guidelines on obligations for General-Purpose AI providers” 2025年11月)

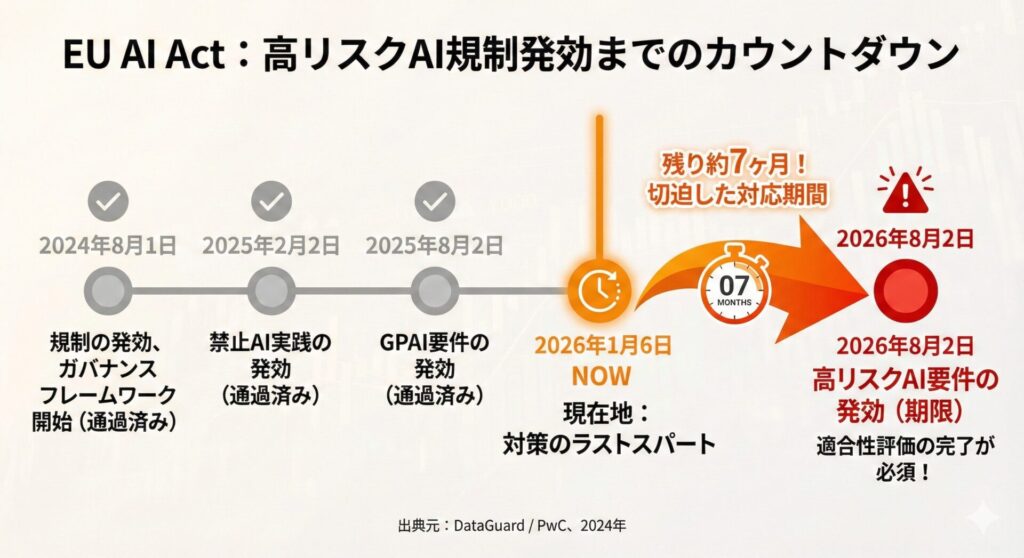

実装スケジュールと重要な期限

EU AI Actは一度にすべての要件が発効するのではなく、段階的に実装されます。

期限 | 発効する要件 |

2024年8月1日 | 規制の発効、ガバナンスフレームワーク開始 |

2025年2月2日 | 禁止AI実践の発効(8カテゴリーが違法に)※既に発効済み |

2025年8月2日 | GPAI要件の発効 ※既に発効済み |

2026年8月2日 | 高リスクAI要件の発効 |

2027年8月2日 | 完全対応(その他の規制製品に組み込まれたAIシステム) |

(出典:DataGuard “EU AI Act Timeline: Key Compliance Dates & Deadlines” / PwC “The EU AI Act: Compliance and transformation” 2024年12月)

現在の状況(2026年1月6日時点)

- ✅ 禁止AI実践は既に発効済み(2025年2月2日発効)

- ✅ GPAI要件は既に発効済み(2025年8月2日発効)

- ⏳ 高リスクAI要件は約7ヶ月後に発効(2026年8月2日)

- ⏳ 完全対応は約1年7ヶ月後(2027年8月2日)

【2025年11月時点の最新動向】

欧州委員会は「Digital Omnibus on AI」提案を発表し、高リスクAI要件の適用を2027年12月まで遅延する可能性を示しました。ただし、この提案はまだ正式採択されておらず、2026年8月2日の期限は現時点で有効です。企業は現行の期限を前提に対応を進めることが推奨されます。

この提案の最新状況は、欧州委員会の公式サイトで確認できます。

(出典:Reuters 2025年11月19日 / Morrison Foerster 2025年11月30日)

日本の中小企業が対象になるケース

「うちの会社は関係ない」と思っていませんか?

よくある誤解

- 「うちはEUに拠点がないから関係ない」→ 誤りです

- 「うちは中小企業だから除外される」→ 誤りです

- 「うちはB2Bだから関係ない」→ 誤りです

EU市場にAI製品・サービスを提供する場合、企業規模に関わらず適用されます。B2B取引でも、EU企業がそのAIを使用すれば適用対象です。

具体的なシナリオ

シナリオ1:AIチャットボット提供企業

ある日本のSaaS企業が、欧州の顧客向けにカスタマーサポート用AIチャットボットを提供。このチャットボットが採用スクリーニングにも使用される場合、高リスクAI(雇用カテゴリー)に該当し、2026年8月2日までにコンプライアンスが必須となります。

シナリオ2:顔認証技術の提供

日本企業が開発した顔認証システムを、EU企業がオフィスの入退室管理に使用。生体認証(Annex III)に該当し、高リスクAI要件が適用されます。

シナリオ3:信用スコアリングAI

金融データ分析サービスを提供する日本企業が、EU銀行のローン審査支援AIを開発。「基本的公共サービス」カテゴリーの高リスクAIに該当し、2026年8月2日までの対応が必須です。

シナリオ4:製造業の品質検査AI

日本の製造業企業が、EU向け製品の製造ラインで品質検査AIを使用。個人データを処理せず、製品の欠陥を検出するのみの場合は最小限リスクAIに該当し、特定の規制要件はありません。ただし、従業員のAIリテラシー向上は推奨されます。

シナリオ5:汎用AIモデルの提供

日本企業が開発した大規模言語モデルをEU市場で提供。GPAI要件は2025年8月2日に既に発効しているため、技術文書、学習データ要約の公開が既に義務となっています。

【GPAIプロバイダーへの重要なお知らせ】

GPAIモデルをEU市場で提供している企業は、2025年8月2日時点で既に規制対象です。まだ対応していない場合は、直ちに技術文書の作成、EU認定代理人の設置を開始してください。

プロバイダー(提供者)の義務

EU AI Actでは、AIシステムを開発・提供する企業を「プロバイダー」と呼びます。

プロバイダーとは

- AIシステムを開発・製造し、市場に提供する企業

- 自社の名前またはブランドでAIシステムを販売する企業

- 既存のAIシステムを大幅に改変してEU市場に提供する企業

高リスクAIプロバイダーの12の主要義務

- リスク管理システムの構築

- 技術文書の作成・維持(10年間保持)

- データガバナンスとデータ管理

- 品質管理システムの実装

- ログ記録の自動生成

- 透明性と情報提供(ユーザー向け詳細指示書)

- 人的監視を可能にする設計

- 正確性・堅牢性・サイバーセキュリティの確保

- 適合性評価の実施

- EU適合宣言書の作成

- CEマークの表示

- EUデータベースへの登録

(出典:EU AI Act Article 16)

非EU企業の特別義務:EU認定代理人の設置

日本企業のような非EU企業が高リスクAIシステムまたはGPAIモデルをEU市場に提供する場合、EU域内に「認定代理人」を設置する義務があります。

認定代理人とは、EU監督当局との連絡窓口として機能する公式な代理人です。EU内に拠点を持つ法律事務所、コンサルティング会社、代理人サービス企業と書面契約を締結します。

GPAIモデルを提供している企業は、2025年8月2日の発効日時点で既にこの義務が適用されています。高リスクAIシステムを提供する企業は、2026年8月2日までに認定代理人を設置する必要があります。

(出典:Whisperly.ai “Authorized Representative (EU AI Act) 2025” 2025年10月)

デプロイヤー(使用者)の義務

自社の業務でAIシステムを使用する企業は「デプロイヤー」として、別途の義務が課されます。

デプロイヤーの8つの主要義務

- 基本的人権影響評価(FRIA)の実施:公的機関、または、ローン・保険などの提供企業が対象

- 人的監視の実装:有能な人間によるAI出力の確認・承認体制の構築

- 入力データの品質管理:AIが使用するデータの正確性・完全性の確保

- 継続的な監視とログレビュー:AIシステムの異常・不具合の検出

- プロバイダーへの報告:重大なリスクやインシデントの報告

- 使用指示の遵守:プロバイダーが提供する使用説明書に従う

- 従業員・関係者への通知:高リスクAIが使用されることの事前告知

- システム一時停止権の行使:リスク状態または意図通りに動作していない場合の停止

(出典:Latham & Watkins “EU AI Act Obligations for Deployers of High-Risk AI Systems”)

コンプライアンスコストの現実

中小企業にとって気になるのは、対応にかかるコストです。

コスト推定の幅

複数の調査機関が推定を出していますが、幅があります。

Center for Data Innovation(CDI)の推定

- 中小企業(従業員50人以下、売上1,000万ユーロ)が高リスクAI製品1つに対して負担する総コンプライアンスコスト:最大40万ユーロ

- 内訳:品質管理システム(QMS)構築19万3,000〜33万ユーロ、年間維持費7万1,400ユーロ

- 売上1,000万ユーロの企業の場合、利益率10%とすると、40万ユーロのコストは利益の40%減少を意味する

(出典:Center for Data Innovation “Artificial Intelligence Act” 2021年)

SME向け簡易推定

- 簡易的な推定:1万〜6万ドル(約110万〜660万円)

(出典:UMU “What is the estimated cost for SMEs to comply with the EU AI Act?” 2025年11月)

重要な注意点

- 既存の品質管理システムがある企業はコストが削減される

- AIシステムの複雑さによってコストは大きく変動

- SME向け支援措置を活用することでコスト削減が可能

SME向けコスト削減支援措置

EU AI Actには、中小企業の負担を軽減するための措置が含まれています。

- 規制サンドボックスへの優先アクセス(無料)

- 簡素化された技術文書テンプレート(マイクロ企業・小規模企業向け)

- 適合性評価料金の割引

- 単一情報プラットフォーム(SME向けガイダンス提供)

- 啓発・研修プログラム(無料)

- 専門の相談窓口(無料)

罰金と法的責任

違反した場合の罰金は非常に重いです。

違反の種類 | 最大罰金 |

禁止AI実践の違反 | 3,500万ユーロまたは総売上7% |

高リスクAIの要件違反 | 3,000万ユーロまたは総売上6% |

その他の違反 | 1,500万ユーロまたは総売上3% |

(出典:Mayer Brown “EU AI Act: Ban on certain AI practices and requirements for AI literacy” 2025年1月)

日本企業への影響シミュレーション

- 売上100億円の中小企業が禁止AI実践で違反した場合:最大7億円の罰金

- 売上1,000億円の中堅企業が高リスクAI要件に違反した場合:最大60億円の罰金

罰金以外にも、製品回収命令、民事訴訟(被害者からの損害賠償請求)、営業停止、評判リスクなどの法的責任があります。

中小企業向け3フェーズ実行プラン

ここからは、具体的に何をすべきかを3つのフェーズに分けて解説します。

フェーズ1:即時対応(今すぐ)

ステップ1:AIシステムの棚卸し(所要時間:2〜5時間)

社内で使用・提供しているすべてのAIシステムをリストアップします。

チェックリスト形式で確認してください。

- カスタマーサポートでAIチャットボットを使用していますか?

- 採用プロセスで履歴書スクリーニングAIを使用していますか?

- 従業員監視や勤怠管理でAIを使用していますか?

- 与信審査や保険料決定でAIを使用していますか?

- 製造ラインで品質検査AIを使用していますか?

- 顔認証システムを使用していますか?

- マーケティングでAI推奨エンジンを使用していますか?

ステップ2:禁止AI実践の確認(所要時間:1〜2時間)

8つの禁止カテゴリーに該当していないか確認します。特に注意すべき項目:

- 採用プロセスで感情分析を使用していないか

- 従業員監視で感情認識を使用していないか

- 顔認証データベースをウェブスクレイピングで拡張していないか

この規定は既に発効しているため、該当する場合は直ちに使用を停止する必要があります。

ステップ3:責任体制の確立(所要時間:半日)

- AIコンプライアンス責任者を指名

- 内部ワーキンググループを組織(IT、法務、人事、営業部門から)

- 月次ミーティングのスケジュール設定

フェーズ2:準備期間(現在〜2026年6月)

ステップ4:AIシステムのリスク分類(所要時間:3〜5時間)

各AIシステムを4つのリスクレベルに分類します。

判定質問セット:

- そのシステムは生体認証(顔認証など)を使用していますか? → はい:高リスク

- 雇用・昇進・解雇の判定に使用されていますか? → はい:高リスク

- 教育成績評価に使用されていますか? → はい:高リスク

- 信用スコアリングや保険料決定に使用されていますか? → はい:高リスク

- 公共サービス(福祉給付など)へのアクセス判定に使用されていますか? → はい:高リスク

- 重要インフラ(交通、電力など)の管理に使用されていますか? → はい:高リスク

ステップ5:EU認定代理人の選任(必要な企業のみ、所要時間:2〜4週間)

対象:高リスクAIをEU市場に提供する企業

選任方法:

- EU内の法律事務所、コンサルティング会社、代理人サービス企業をリサーチ

- 複数社から見積もりを取得

- 書面による委任契約を締結

ステップ6:技術文書の準備開始(所要時間:1〜3ヶ月)

高リスクAIプロバイダーは以下の文書を準備します。

- モデルのアーキテクチャと技術仕様

- 学習・テスト・検証データの詳細

- 計算資源と消費エネルギー

- 意図した用途と使用方針

フェーズ3:本格的コンプライアンス実装(2026年2月〜2026年8月2日)

ステップ7:高リスクAIシステムの適合性評価

2026年8月2日までに完了させます。

- Notified Body(認定試験機関)の特定

- 評価申請と技術文書一式の提出

- 評価実施(通常3〜12ヶ月、複雑なシステムはそれ以上)

- 認可取得後、CEマーク表示とEU適合宣言書発行

2026年8月2日期限を考慮すると、2026年2月までに評価申請を開始することが推奨されます。

(出典:Eyreact “Notified Bodies in the EU AI Act” 2025年7月)

ステップ8:リスク管理システムの実装

- 定期的なリスク評価(月次または四半期)

- バイアス・性能低下の監視

- ユーザーからの苦情処理体制

- システム改変時の再評価

ステップ9:人的監視体制の構築

- 監視者の選定とトレーニング

- AIの限界と過度な依存防止の啓発

- オーバーライド権限の付与

- トレーニング記録の保持

地方自治体への影響

日本の地方自治体がEU AI Actの影響を受けるケースは限定的ですが、以下の場合は注意が必要です。

影響を受ける可能性があるケース

- 姉妹都市提携とデジタル交流:EU加盟国の姉妹都市とデジタルプラットフォームを共同開発し、市民向けサービスにAIを使用する場合

- 海外ベンダーからのAI調達:EU企業が開発したAI製品を調達する場合、プロバイダーがEU AI Act準拠を証明しているか確認が重要

- スマートシティ技術の国際展開:日本の自治体が開発したスマートシティソリューションをEU都市に輸出する場合

日本の地方自治体のDX現状

自治体の48.87%が首長がDXへの強い意志を示していると回答していますが、地域産業のAI・IoT採用支援を実施している自治体は一桁台に留まっています。小規模自治体ほど労働コスト削減や自動化に焦点を当てる傾向があります。

(出典:経済産業研究所 2022年調査)

地方自治体IT担当者が取るべきアクション

- EU AI Actの基礎知識習得(職員向け研修の実施)

- AI調達ガイドラインの策定(ベンダー選定時のEU AI Act準拠確認項目)

- 国際交流事業でのAI使用の見直し

よくある質問(FAQ)

Q1. うちの会社は中小企業ですが、本当に対象になりますか?

はい、企業規模に関わらず、EU市場にAI製品・サービスを提供する場合は対象になります。EU AI Actには企業規模による除外規定はありません。ただし、中小企業向けの支援措置(規制サンドボックス、簡素化された文書、料金割引など)は利用できます。

Q2. ChatGPTやGeminiを社内で使用しているだけですが、対応が必要ですか?

社内業務でChatGPTなどのツールを使用するだけであれば、プロバイダー(OpenAI、Googleなど)がコンプライアンス義務を負います。ただし、従業員のAIリテラシー向上は推奨されており、データ保護(GDPR)への配慮は必要です。

Q3. 日本国内だけでビジネスしていますが、影響はありますか?

日本国内のみでビジネスを行い、EU市場への提供がない場合、EU AI Actの対象外です。ただし、将来的にEU市場への参入を検討している場合は、早めに対応準備を始めることが推奨されます。

Q4. EU AI Actへの対応費用はどれくらいかかりますか?

推定は幅がありますが、中小企業が高リスクAI製品1つに対して負担する総コストは1万〜40万ユーロ(約110万〜4,400万円)と推定されています。既存の品質管理システムがある企業や、SME向け支援措置を活用する企業はコストを削減できます。

Q5. 2026年8月2日までに対応が間に合わない場合はどうなりますか?

期限までに対応が完了していない高リスクAIシステムは、EU市場での提供・使用が違法となります。罰金(最大3,000万ユーロまたは売上の6%)や製品回収命令のリスクがあります。早めに専門家に相談し、対応計画を立てることが重要です。

Q6. どの専門家に相談すればよいですか?

以下の専門家への相談が推奨されます。

- EU AI規制専門の法律事務所:コンプライアンス戦略、契約交渉

- AIシステム評価企業:リスク分類、技術文書作成

- EU認定代理人サービス提供企業:代理人の選任と契約

- JETRO(日本貿易振興機構):EU規制情報、現地パートナー紹介

Q7. オープンソースAIは除外されますか?

一部除外があります。オープンソースライセンスで公開され、パラメータ・ウェイト・モデル情報が無料で入手可能なGPAIモデルは、多くの義務が免除されます。ただし、商用利用や高リスク用途に統合される場合は、依然として一部要件が適用される可能性があります。

参考リソース

公式リソース

日本語リソース

まとめ:今すぐやるべき3つのこと

EU AI Actへの対応は、複雑に見えますが、まずは以下の3つから始めてください。

- AIシステムの棚卸し 社内で使用・提供しているすべてのAIシステムをリストアップします。これが対応の出発点です。

- 禁止AI実践の確認 8つの禁止カテゴリーに該当していないか、今すぐ確認してください。この規定は既に発効しています。

- 責任体制の確立 AIコンプライアンス責任者を指名し、対応を進める体制を整えます。

- AIシステムの棚卸し 社内で使用・提供しているすべてのAIシステムをリストアップします。これが対応の出発点です。

EU AI Actの高リスクAI要件の発効まで、あと約7ヶ月です。適合性評価には3〜12ヶ月かかる場合もあるため、2026年2月までに評価申請を開始することが推奨されます。早めの対応開始が、コスト削減とリスク回避の鍵となります。

マーキュリープロジェクトオフィスからのご提案

私たちマーキュリープロジェクトオフィスは、20年以上にわたり、中小企業のデジタル活用を支援してきました。

EU AI Actへの対応は、単なる「規制対応」ではなく、自社のAI活用を見直し、より良いシステムを構築する機会でもあります。

私たちは、以下のような支援を提供しています。

AI活用診断・棚卸し支援 自社で使用しているAIシステムの洗い出しとリスク分類を支援します。

生成AI導入支援 業務分析から活用領域の特定、PoC実施、本格導入まで、段階的にサポートします。

回答生成エンジン「Symphony Base」 自社データと生成AIを組み合わせた、カスタムチャットボットの構築を支援します。EU AI Actの透明性要件にも対応した設計が可能です。

「何から始めればいいか分からない」という段階でも構いません。まずはお気軽にご相談ください。

※この記事は、信濃ロボティクスイノベーションズ合同会社の開発するマルチAIアシスタント「secondbrain」を利用して執筆しています。